ابزارهای هوش مصنوعی (AI) که توضیحات متنی را به تصاویر و ویدیوها ترجمه می کنند، به سرعت در حال پیشرفت هستند.

درست همانطور که بسیاری از محققان از ChatGPT برای متحول کردن فرآیند نگارش علمی استفاده می کنند، برخی دیگر نیز از تولیدکنندگان تصاویر هوش مصنوعی مانند Midjourney، Stable Diffusion و DALL-E برای کاهش زمان و تلاشی که برای تهیه نمودارها و تصاویر لازم است، بهره می برند. با این حال، محققان هشدار می دهند که این ابزارهای هوش مصنوعی ممکن است باعث افزایش داده های جعلی و تصاویر علمی نادرست شوند.

همانطور که در این مقاله از یابش میخوانید، مجله نیچر به بررسی نحوه استفاده محققان از این ابزارها و تأثیر احتمالی محبوبیت روزافزون آنها بر علم می پردازد.

ابزارهای تبدیل متن به تصویر چگونه کار میکنند؟

بسیاری از ابزارهای هوش مصنوعی تبدیل متن به تصویر، مانند Midjourney و DALL-E، بر روی الگوریتمهای یادگیری ماشین به نام مدلهای انتشار تکیه میکنند. این مدلها برای تشخیص پیوند بین میلیونها تصویر جمعآوریشده از اینترنت و توضیحات متنی آن تصاویر آموزش داده میشوند. پیشرفت این مدلها در سالهای اخیر به دلیل پیشرفت در سختافزار و در دسترس بودن مجموعه دادههای بزرگ برای آموزش، حاصل شده است. مدلهای انتشار پس از آموزش میتوانند از طریق اعلانهای متنی، تصاویر جدیدی را تولید کنند.

محققان از این ابزارها برای چه کاری استفاده میکنند؟

برخی از محققان از تصاویر تولید شده توسط هوش مصنوعی برای تصویرسازی روشها در مقالات علمی استفاده میکنند. برخی دیگر از آنها برای تبلیغ مقالات در پستهای رسانههای اجتماعی یا برای جذابتر کردن اسلایدهای ارائه استفاده میکنند.

خوان رودریگز، محقق هوش مصنوعی در ServiceNow Research در مونترال کانادا میگوید: «آنها از ابزارهایی مانند DALL-E 3 برای تولید تصاویر زیبا برای قاببندی مفاهیم تحقیقاتی استفاده میکنند.»

او میگوید: «من پنجشنبه گذشته در مورد کارم صحبت کردم و از DALL-E 3 برای تولید تصاویر جذاب برای جلب توجه مردم استفاده کردم».

رودریگز میگوید: ابزارهای تبدیل متن به ویدیو نیز در حال افزایش هستند، اما به نظر میرسد توسط محققانی که به طور فعال این ابزارها را توسعه یا مطالعه نمیکنند، کمتر مورد استفاده قرار میگیرند. با این حال، این موضوع میتواند به زودی تغییر کند.

ماه گذشته، OpenAI، خالق ChatGPT در سانفرانسیسکو، کالیفرنیا، ویدیوهایی را منتشر کرد که توسط یک ابزار تبدیل متن به ویدیو به نام Sora تولید شده بود.

رودریگز میگوید: «با توجه به آزمایشهایی که با Sora دیدیم، به نظر میرسد روش آنها برای دستیابی سریع به نتایج بسیار قویتر است».

او میگوید: «ما در زمینه تبدیل متن به ویدیو در مراحل ابتدایی هستیم، اما حدس میزنم امسال متوجه خواهیم شد که این فناوری چگونه توسعه پیدا میکند».

مزایای استفاده از این ابزارها چیست؟

ابزارهای هوش مصنوعی تولیدکننده محتوا میتوانند زمان لازم برای تولید تصاویر یا نمودارها برای مقالات، پوسترهای کنفرانس یا ارائهها را کاهش دهند. به طور سنتی، محققان از مجموعهای از ابزارهای غیر هوش مصنوعی مانند PowerPoint، BioRender و Inkscape استفاده میکنند.

«اگر واقعاً نحوه استفاده از این ابزارها را بدانید، میتوانید تصاویر واقعاً تأثیرگذاری بسازید، اما این کار زمانبر است».

رودریگز میگوید، ابزارهای هوش مصنوعی همچنین میتوانند کیفیت تصاویر را برای محققانی که در ترجمه مفاهیم علمی به کمکهای بصری با مشکل مواجه هستند، بهبود بخشند. او میگوید با هوش مصنوعی تولیدکننده محتوا، محققان همچنان ایده اصلی تصویر را ارائه میدهند، اما میتوانند از هوش مصنوعی برای اصلاح و بهبود آن استفاده کنند.

چه ریسکهایی وجود دارد؟

در حال حاضر، ابزارهای هوش مصنوعی میتوانند آثار هنری و برخی تصاویر را به طور قانعکنندهای تولید کنند، اما هنوز قادر به ساخت نمودارهای علمی پیچیده با توضیحات متنی نیستند.

خوان رودریگز میگوید: «آنها متن را به درستی نمایش نمیدهند – متن گاهی اوقات خیلی کوچک، بسیار بزرگتر یا چرخیده است.»

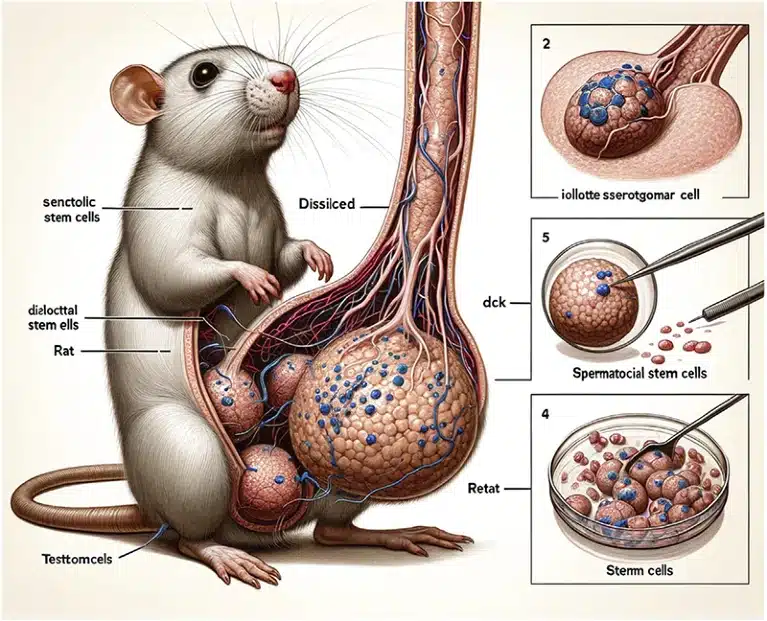

نوع مشکلاتی که میتواند ایجاد شود در مقالهای که در اواسط فوریه در Frontiers in Cell and Developmental Biology منتشر شد، به وضوح بیان شد. در این مقاله، محققان از Midjourney برای تصویربرداری از اندامهای تولیدمثلی موش صحرایی استفاده کردند. نتیجهای که از داوری همتا عبور کرد، یک جوندگان کارتونی با اندام تناسلی غولپیکر به شکل طنزآمیز بود که با حروف بیمعنی شرح داده شده بود.

هنری شارپ، هنرمند باستانشناسی و دانشجوی دیرینهشناسی در دانشگاه آلبرتا در ادمونتون کانادا میگوید: «این واقعاً تصویری عجیب و غریب از یک موش صحرایی بود.» گیوم کابناک، که در حال مطالعه متون جعلی تولید شده توسط هوش مصنوعی در دانشگاه تولوز فرانسه است، میگوید: «این حادثه یکی از «بزرگترین موارد» مربوط به تصاویر تولید شده توسط هوش مصنوعی تا به امروز است.»

پس از اعتراض عمومی محققان، مقاله پس گرفته شد.

خوان رودریگز میگوید، این احتمال وجود دارد که ابزارهای هوش مصنوعی، تولید داده یا مشاهدات جعلی را برای کلاهبرداران علمی آسانتر کند. او میگوید مقالات علمی ممکن است نه تنها حاوی متن تولید شده توسط هوش مصنوعی، بلکه شامل نمودارها و تصاویر تولید شده توسط هوش مصنوعی نیز باشند. در حال حاضر هیچ روش قابل اطمینانی برای تشخیص چنین تصاویر و ویدیوهایی وجود ندارد.

رودریگز میگوید: «این موضوع قرار است کاملاً وحشتناک شود، زیرا ما با انبوهی از دادههای جعلی و به صورت مصنوعی تولید شده بمباران خواهیم شد.» برای مقابله با این مشکل، برخی از محققان در حال توسعه روشهایی برای تزریق سیگنالهایی به تصاویر تولید شده توسط هوش مصنوعی هستند تا امکان شناسایی آنها را فراهم آورند.

چرا برخی از حوزهها نسبت به این فناوری واکنش منفی نشان دادهاند؟

ماه گذشته، شارپ نظرسنجیای را در پلتفرمهای رسانههای اجتماعی از جمله X، فیسبوک و اینستاگرام راهاندازی کرد که دیدگاههای حدود ۹۰ دیرینهشناس را در مورد تصاویر تولید شده توسط هوش مصنوعی از موجودات باستانی بررسی میکرد. شارپ میگوید: «تنها یک نفر از هر چهار دیرینهشناس حرفهای فکر میکرد که باید به هوش مصنوعی اجازه داده شود تا در انتشارات علمی حضور داشته باشد.»

او میافزاید، تصاویر تولید شده توسط هوش مصنوعی از موجودات یا فسیلهای باستانی میتوانند هم دانشمندان و هم مردم را گمراه کنند. «این تصاویر نادرست هستند، تنها کاری که انجام میدهند کپیبرداری از چیزهای موجود است و در واقع نمیتوانند بروند و مقالات را بخوانند.» شارپ میگوید بازسازی گامبهگام موجودات باستانی به صورت دستی، با مشورت با دیرینهشناسان، میتواند ویژگیهای تشریحی قابل قبولی را آشکار کند – فرآیندی که هنگام استفاده از هوش مصنوعی کاملاً از بین میرود.

دیرینههنرمندان و دیرینهشناسان دیدگاههای مشابهی را با استفاده از هشتگ PaleoAgainstAI در X به اشتراک گذاشتهاند.

ناشران چگونه با محبوبیت این ابزارها سازگار میشوند؟

سیاستهای مجلات در مورد تصاویر تولید شده توسط هوش مصنوعی متفاوت است. اشپرینگر نیچر (Springer Nature) استفاده از تصاویر، ویدیوها و تصاویرسازیهای تولید شده توسط هوش مصنوعی را در اکثر مقالات ژورنالی که به طور خاص در مورد هوش مصنوعی نیستند، ممنوع کرده است (تیم خبری Nature از ناشر خود، Springer Nature مستقل است).

اشپرینگر نیچر (Springer Nature) استفاده از تصاویر، ویدیوها و تصاویرسازیهای تولید شده توسط هوش مصنوعی را در اکثر مقالات ژورنالی که به طور خاص در مورد هوش مصنوعی نیستند، ممنوع کرده است.

مجلههای مجموعه Science اجازه استفاده از متن، نمودار یا تصاویر تولید شده توسط هوش مصنوعی را بدون اجازه صریح از سردبیران نمیدهند، مگر اینکه مقاله به طور خاص در مورد هوش مصنوعی یا یادگیری ماشین باشد.

PLOS ONE استفاده از ابزارهای هوش مصنوعی را مجاز میداند، اما تأکید میکند که محققان باید ابزاری که از آن استفاده کردهاند، نحوه استفاده از آن و چگونگی تأیید کیفیت محتوای تولید شده را به صراحت اعلام کنند.

منبع:

https://www.nature.com/articles/d41586-024-00659-8