چگونه می توان از هوش مصنوعی برای تحقیقات علوم اجتماعی استفاده کرد و در عین حال شفافیت و تکرارپذیری را نیز تضمین کرد؟

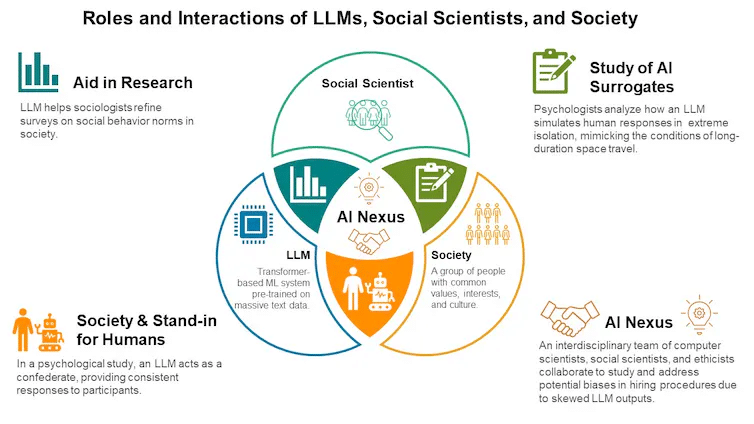

تحقیقات علوم اجتماعی سنتی بر روش هایی مانند پرسشنامه، آزمون های رفتاری، مطالعات مشاهده ای و آزمایش ها متکی بوده است. این روش ها معمولاً دشوار و زمان بر هستند و به حجم زیادی از داده های انسانی نیاز دارند. مدل های زبانی بزرگ به طور فزاینده ای توانایی تقلید پاسخ های شبیه انسان را پیدا می کنند. این مدل ها می توانند برای جمع آوری داده ها از طریق اینترنت، تجزیه و تحلیل داده ها و آزمایش نظریه ها استفاده شوند.

استفاده از هوش مصنوعی در تحقیقات

چندین روش ممکن برای استفاده از هوش مصنوعی در تحقیقات علوم اجتماعی وجود دارد. اولاً، برخلاف محققان انسانی، سیستمهای هوش مصنوعی میتوانند بدون وقفه کار کنند و تفسیرهایی را در زمان واقعی از جامعه جهانی و سریع ما ارائه دهند.

هوش مصنوعی میتواند با پردازش حجم عظیمی از مکالمات انسانی از اینترنت و ارائه بینشی در مورد روندهای اجتماعی و رفتار انسانی، به عنوان یک دستیار پژوهشی عمل کند.

امکان دیگر می تواند استفاده از هوش مصنوعی به عنوان بازیگر در آزمایشهای اجتماعی باشد. یک جامعهشناس میتواند از مدلهای زبانی بزرگ برای شبیهسازی تعاملات اجتماعی بین افراد استفاده کند تا بررسی کند که چگونه ویژگیهای خاص، مانند گرایشهای سیاسی، پیشینه قومی یا جنسیت بر تعاملات بعدی تأثیر میگذارد.

شگفتانگیزتر از همه، مدل های زبان بزرگ می توانند به عنوان جایگزینی برای شرکت کنندگان انسانی در مرحله اولیه جمع آوری داده ها عمل کنند.

به عنوان مثال، یک دانشمند علوم اجتماعی می تواند از هوش مصنوعی برای آزمایش ایده ها برای مداخلات برای بهبود تصمیم گیری استفاده کند. این روش کار می کند: اول، دانشمندان از هوش مصنوعی می خواهند که یک گروه جمعیت هدف را شبیه سازی کند. در مرحله بعد، دانشمندان نحوه واکنش یک شرکت کننده از این گروه را در یک سناریوی تصمیم گیری بررسی می کنند. سپس دانشمندان از بینشهای شبیهسازی برای آزمایش امیدوارکنندهترین مداخلات استفاده میکنند.

موانع پیش رو

در حالی که پتانسیل یک تغییر اساسی در تحقیقات علوم اجتماعی عمیق است، موانعی که در پیش رو دارند نیز عمیق هستند.

اول، روایت در مورد تهدیدات وجودی از AI می تواند به عنوان یک مانع باشد. برخی از کارشناسان هشدار میدهند که هوش مصنوعی پتانسیل ایجاد آیندهای دیستوپیایی را دارد ، مانند Skynet بدنام از فرنچایز ترمیناتور که در آن ماشینهای حساس منجر به سقوط بشریت میشوند.

این هشدارها ممکن است تا حدودی نادرست و یا حداقل زودرس باشند. از لحاظ تاریخی، کارشناسان در زمینه پیشبینی تغییرات اجتماعی کارنامه ضعیفی از خود نشان دادهاند .

هوش مصنوعی امروزی حساس نیست. این یک مدل ریاضی پیچیده است که برای تشخیص الگوها در داده ها و انجام پیش بینی آموزش دیده است. علیرغم ظاهر انسانمانند پاسخهای مدلهایی مانند ChatGPT، این مدلهای زبان بزرگ، پایههای انسانی نیستند .

مدلهای زبانی بزرگ بر روی تعداد زیادی از محصولات فرهنگی از جمله کتاب، متون رسانههای اجتماعی و پاسخهای یوتیوب آموزش دیدهاند. در بهترین حالت، آنها نشان دهنده خرد جمعی ما هستند تا اینکه یک عامل فردی باهوش باشند.

خطرات فوری ناشی از هوش مصنوعی کمتر در مورد شورش احساسی و بیشتر در مورد مسائل پیش پا افتاده است که با این وجود قابل توجه هستند.

تعصب یک نگرانی عمده

نگرانی اصلی در کیفیت و وسعت دادههایی است که مدلهای هوش مصنوعی، از جمله مدلهای زبان بزرگ را آموزش میدهند.

اگر هوش مصنوعی اساساً بر روی داده های یک جمعیت شناسی خاص آموزش داده شود – مثلاً افراد انگلیسی زبان از آمریکای شمالی – بینش آن منعکس کننده این سوگیری های ذاتی خواهد بود.

این بازتولید سوگیری یک نگرانی بزرگ است زیرا میتواند تفاوتهایی را که دانشمندان علوم اجتماعی در تحقیقات خود برای کشف آن تلاش میکنند، تشدید کند. ترویج عدالت بازنمایی در دادههای مورد استفاده برای آموزش مدل های هوش مصنوعی ضروری است.

اما چنین انصافی تنها با شفافیت و دسترسی به اطلاعات مربوط به مدلهای هوش مصنوعی بر روی دادهها قابل دستیابی است . تا کنون، چنین اطلاعاتی برای همه مدل های تجاری یک راز است.

با آموزش مناسب این مدل ها، دانشمندان علوم اجتماعی قادر خواهند بود پاسخ های رفتاری انسان را در تحقیقات خود با دقت بیشتری شبیه سازی کنند.

سواد هوش مصنوعی کلیدی است

تهدید اطلاعات نادرست یکی دیگر از چالش های اساسی است. سیستمهای هوش مصنوعی گاهی اوقات حقایق توهمآمیزی تولید میکنند – اظهاراتی که معتبر به نظر میرسند، اما نادرست هستند. از آنجایی که هوش مصنوعی مولد فاقد آگاهی است، این توهمات را بدون هیچ نشانه ای از عدم اطمینان ارائه می دهد.

افراد ممکن است بیشتر به دنبال چنین اطلاعاتی با صدای مطمئن باشند و آن را به اطلاعات کمتر قطعی اما دقیق تر ترجیح دهند. این پویایی می تواند به طور ناخواسته اطلاعات نادرست را منتشر کند و محققان و عموم را به طور یکسان گمراه کند.

علاوه بر این، در حالی که هوش مصنوعی فرصتهای تحقیقاتی را برای محققان علاقهمند باز میکند، اگر کاربران فقط به دنبال اطلاعاتی باشند که با باورهای قبلیشان همسو باشد، میتواند بهطور ناخواسته به سوگیری تأییدیه دامن بزند.

اهمیت سواد هوش مصنوعی را نمی توان بیش از حد مورد تاکید قرار داد. دانشمندان علوم اجتماعی باید به کاربران در مورد نحوه کار با ابزارهای هوش مصنوعی و ارزیابی انتقادی خروجی های آنها آموزش دهند.

ایجاد تعادل

همانطور که به جلو می رویم، باید با چالش های بسیار واقعی که هوش مصنوعی ارائه می کند، از بازتولید سوگیری گرفته تا اطلاعات نادرست و سوء استفاده احتمالی دست و پنجه نرم کنیم. تمرکز ما نباید روی جلوگیری از یک سناریوی دور از اسکای نت باشد، بلکه باید روی مسائل مشخصی باشد که هوش مصنوعی اکنون روی میز آورده است.

همانطور که ما به کشف پتانسیل تحول آفرین هوش مصنوعی در علوم اجتماعی ادامه می دهیم، باید به یاد داشته باشیم که هوش مصنوعی نه دشمن ما است و نه نجات دهنده ما – این یک ابزار است. ارزش آن در نحوه استفاده ما از آن نهفته است. این توانایی بالقوه ای برای غنی سازی خرد جمعی ما دارد، اما به همان اندازه می تواند حماقت انسانی را تقویت کند.

با ایجاد تعادل بین استفاده از پتانسیل هوش مصنوعی و مدیریت چالشهای ملموس آن، میتوانیم ادغام هوش مصنوعی در علوم اجتماعی را مسئولانه، اخلاقی و به نفع همه هدایت کنیم.